5年ぐらい前に海外の論文でツイッターのつぶやきを分析したら株価予測に成功したというのがあった。投資家が投資判断に用いる景気動向指数だって、消費者の気分を反映している指標があるのでさもありなんである。

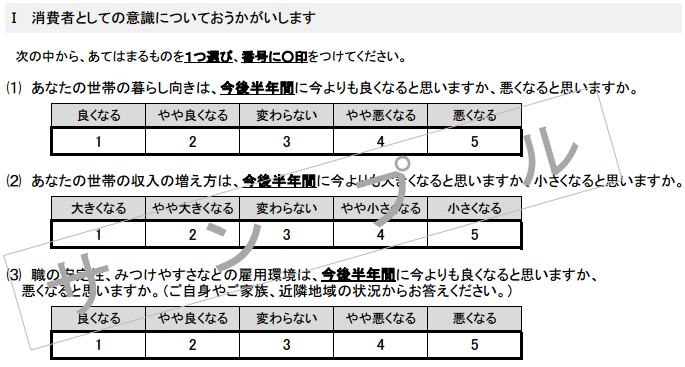

景気動向指数のうち景気動向より先行するとされる、消費者態度指数(内閣府経済社会総合研究所、消費動向調査)や、中小企業売上げ見通しDI(中小企業景況調査)なんかは、「景気どうよ?」ってアンケートを積み上げたにすぎない。

https://www.jfc.go.jp/n/findings/tyousa_sihanki.html

http://www.esri.cao.go.jp/jp/stat/shouhi/chousahyou_sample2016.pdf

自分も日本語でもやってみようと、自分のフォロアーのつぶやきをDBにぶっこんで形態素解析に食わせて、感情解析API通したりなんだりして眺めてみたことがある。結果、感情解析エンジンのクオリティの問題か、自分のフォローしている人たちの問題か、投資に使えるほどまでに強そうな相関はみえなかった。

しかし、助詞(~が、~の、~を)の登場頻度がましたときは株価インデックスのボラティリティ(振幅)がでけぇなーと、グラフをみて漠然と感じた。ニュースや企業広報などが助詞をきちんとつかった比較的フォーマルなリツイートが増えるためかしらん?などと思ったもんだ。検証はまったくしてない。この程度のシグナルなら企業現在価値計算したりファンダメンタルからやったほうがよさそうだな、ってぐらいだし、自分は学者ではないので、ふーんって眺めて終わるのである。ま、景気動向指標を投資判断でどこまで重要視するのかいなっておはなし。

人工無能

さて、最近の人工知能はツイッターでつぶやくそうな。

マイクロソフトが提供している人工知能女子高生AI日本語版「りんな」や、英語圏で稼働してたらヒットラーを賛否して停止させられた「tay」、中国語圏で稼働している「小冰(Xiaoice)」、みな饒舌だ。

これらは人工知能というよりは人工無能。おっさんたちにはチャットで動いてたBotというと懐かしい。

チャットというより当時はIRCが主戦場で、今はslackに居座っているエージェントBotだろうか。人工無能には今更感があって90年代初頭のパソコン通信時代のOLT(On Line Talk)時代とかから人工無能はあった。

相手が人間ですらないという可能性に思いもよらず、機械相手にチャットしてその反応に怒ったり悲しんだりするものがいたほどだ。(当時のBotは泥酔したよっぱらい並)

チューリングテストは、人間の判定者が言語での会話を行い、相手が人間か機械かを判定するテストであるが、そもそもテストであるとも知らされていない状況下においては、かなりの確率で人間を騙せるのである。有料出合い系サイトで女性と会話しているつもりだったら人口無能だったなんてのはよくある話しだ。(逆にそうじゃないことがないんじゃね?)

そして、テストとわかっている状況下でも人間は機械と人間を区別できなくなった。

チューリングテスト

https://ja.wikipedia.org/wiki/%E3%83%81%E3%83%A5%E3%83%BC%E3%83%AA%E3%83%B3%E3%82%B0%E3%83%BB%E3%83%86%E3%82%B9%E3%83%88

2014年6月7日、ロンドンのテストに「13歳の少年」の設定で参加したロシアのスーパーコンピューターが、30%以上の確率で審査員らに人間と間違われて史上初めての「合格者」となった

文章解釈の精度

人工無能が会話を成立させるためには発言するだけじゃなく、相手が何を言ったかを解釈する必要がある。

こちらの精度もあがっている。

人工知能を東京大学に合格させようというプロジェクトで、2015年の「東ロボくん」の全国模試の偏差値は57.8だった。記憶力が人間とは比べ物にならないのだからあたりまえだろうと思うなかれ、「東ロボくん」は問題文という自然言語で書かれた問題の「文意」を読み取る力があることを意味している。(むしろそこがネック)

求められた問に正答を返せる能力が全国の受験生の上位25%相当に入るようになった。

なにが求められているのかが判断できるようになった。

つまり、そういうことだ。

長文作文

チャットのような短い文だけではなく、長文も書けるようになってきている。

星新一賞で星新一プロジェクトによりつくられたAIが作成した小説が一次審査を突破した。

いくつか作品を読んでみたが立派なものである。(オチの数列がわからないので誰かおしえて)

http://www.fun.ac.jp/~kimagure_ai/

英語圏では新聞やニュースサイトにおける、プロスポーツの結果や株式市場情報など、比較的定型文で書けるものについては既に自動作文によってなされるようになってきている。

さらには、読む読者の住所情報に応じて長文のAI作文がなされるまでになってきたそうだ。

http://business.newsln.jp/news/201511080445270000.html

すこし余談だが、「迷惑メール」があんなアホみたいな文章なのにはわけがあるそうな。本当はもっと巧妙な文章作成できるのだが、しかし、トンチンカンなタイトルや本文にすることで、「正常な判断をできる人間」をふるい落としている。

多くの人が騙されるようなメールを書いてしまうと、「まともな人」から問い合わが来てしまって、そこから通報されたり、嘘だと見抜かれ逮捕される可能性があがってしまうので、彼らの詐欺行為の障害になる。だから、程度の低いメールで騙されれる「間抜けな」な人を探すことに最適化された文章が作成されている。こんな馬鹿みたいな内容を羅列してなにがしたいんだと思うかもしれないが、馬鹿をさがしているのだからそれでいいのだ。なんとも恐ろしい。

逆に標的攻撃型やフィッシングはより巧妙に騙す方向に進化している。なんとも恐ろしい。

嘘をつくAI

1960年代ダートマス会議で人工知能についての話し合われた第一次人工知能ブームの時代にELIZA(イライザ)と呼ばれる人工無能が誕生した。iPhoneを持っている人はsiriに「イライザって誰ですか」聞いてみると、感慨深い答えが返ってくるはずだ。

現代になってELIZAの後輩たちは自然言語を聞き取り、文章を読み取り、そして、文章を書き出し、そして発話できるようになるまでに進化した。(ディクテーションや発話については、またこれだけで一大テーマなので別の回に書く)

人工知能が人間の意図にしたがって人間を騙るだけでなく、やがて自らの判断で嘘をつけるようになる時代がまもなくくるだろう。

囲碁で人間の最高峰に勝ったAIは次はポーカーに歩をすすめている。

ポーカーのなかでも「無制限テキサスホールデム」は掛け金を青天井にあげて相手にハッタリをかますこと、またそれを見抜くことが重要な競技だ。囲碁や将棋のような「二人零和有限確定完全情報ゲーム」から、不完全情報分野に踏み出す。ここでは嘘をつくことが重要になる。

汝は人工知能なりや?

人工知能の騙りに、人間が気がつけなくなる時代はまもなくだ。

参考

Googleは米国時間5月12日、「TensorFlow」で実装されたオープンソースの同社自然言語フレームワーク「SyntaxNet」をリリースした。

http://googleresearch.blogspot.jp/2016/05/announcing-syntaxnet-worlds-most.html

https://github.com/tensorflow/models/tree/master/syntaxnet

https://4.bp.blogspot.com/-1Ntx47T1WvU/VzTF2HgbqrI/AAAAAAAAA_w/UWofRQPhqU0ITD5HPQmEVCrwsEroCN8PQCLcB/s640/long.png

「東ロボくん」偏差値上昇57.8 東大目指す人工知能

山崎啓介2015年11月14日22時56分

全大学の6割にあたる474大学の1094学部で合格の可能性が80%以上と診断される「優等生」に成長した。

2014年の偏差値は47・3

2015年の偏差値は57・8

http://www.asahi.com/articles/ASHCG5F03HCGULBJ00D.html

囲碁でだめなら、お次はポーカーだ──人類に残された「AIとのゲーム」

http://wired.jp/2016/03/21/texas-holdem/

人狼知能プロジェクト

http://aiwolf.org/

コメントを残す