SXSW(サウス・バイ・サウスウエストでPerfumeのライブがあり、その様子がustreamで公開されたようです。SXSWとは「毎年3月にアメリカテキサス州オースティン市で行なわれる、音楽祭・映画祭・インタラクティブフェスティバルなどを組み合わせた大規模イベント」by wikipedia

このステージの生配信された冒頭部分がYouTubeで1カ月間限定公開されいます。

まー、まだ見てないひとは見てください。みたほうがいぃょ。まちげぇねぇ。

おらぁ、ぽかーんとしたね。

すごすぎて意味がわかんねぇや。なんで、答え合わせのない分析でもいっちょやってみたいと思う。技術のほうのブログに書こうとおもったんだけどドメイン失効してたからさ・・・放置されたピケティ連作のブログに紛れ込ませるんだよ!

数年前おこなわれた拡張仮想

渋谷ヒカリエのこけら落としか何かでPerfumeがやったライブで、フロントに貼ったフィルムに3Dホログラフィックを投影されたのがあった。指先につけたメタマテリアルかなにかのマーカーを拾ってそのフィルム上にリアルタイムで描画していくという数年経った今でもぶっとびの魔法のごときテクノロジー。

モニタ越しに覗きこむのがAR:仮想空間拡張なら、Perfumeがやってることは仮想の中でおきていることを現実世界になんとかしてひっぱってきて表現しようという、拡張仮想だよね。なんてことを、前に書いたことがあるんだけど(ドメインごとネットの藻屑に消えたw)、今回のライブのように仮想も現実もまぜごちゃにされると、もう脳みそついていけないよねって感じですよな。

AR?

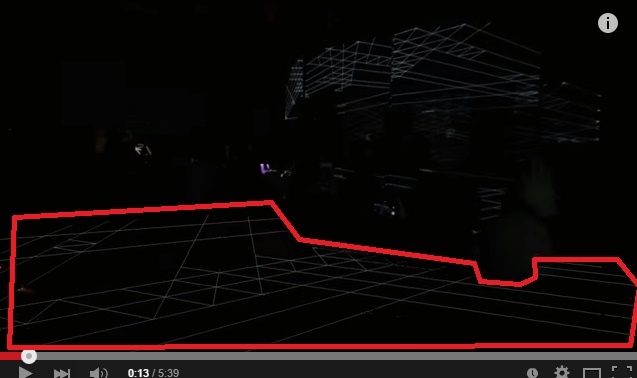

まずわかりやすいところで13秒のところあたりにみえるAR(拡張現実)っぽいなにか。

赤い太線で囲った部分ね。おそらく現実のライブ会場に居る人達には見えないもので、配信映像上で合成された地平のパース線なのではないかな。

これは実にARっぽいんだけど、ステージ上のどこかのマーカーに標準をあわせてるとかでやっているのかな? 人などの障害物を認識しているようにも見えるので、Kinect的な赤外線センサーとかで、奥行きぐらいはとっているかもしれない。

・・・と、まあ、これが単純なARだったら、誰もおどろいちゃくれねぇよ。

ARだけでは説明がつかない。

シームレスなモーフィング

次に、音楽に併せて多視点カメラの切り替えで、ほんげーーーぇぇえ!??ってなるんだけど、このカメラスイッチングがリアルタイム、シームレスモーフィングなんですよ。もう横文字すぎてなんのこっちゃって感じですが。

ひとつひとつ解説をしていきます。

多視点:これはライブを撮影している据え付け型のカメラが複数台あるということです。

スイッチング:カメラの切り替えってやつです。モニタールームで肩にセーターかけたディレクターさんが3カメーとか叫んでるやつですね(?)。これでどこのカメラ映像を使うかはディレクターが決めて、文字通りスイッチングしていくわけですが、普通のカメラワークであればスイッチングを頻繁にやり過ぎると意味がわからなくなるので、アップの絵だったり引きの絵だったり大抵3秒とか5秒づつぐらいは使われます。・・・が、今回はなんと音楽にあわせて1小節とか4分音符ごとにカメラパンパンしてます。酔っちゃう!

モーフィング:で、視点をただパッッパと切り替えるとテレビのリモコンでザッピングしているような感じになっちゃうはずなんですが、今回はカメラ同士の映像の途中をつなぐ中間画像をいくつもつくってモーフィングしてから繋げてるわけですね。

モーフィングというと、Michael Jackson の Black Or Whiteでいろんな人の顔が次々に変わっていくというのの印象が深いかもしれません。

5:28〜のところ。

人の顔は目の位置や鼻の位置など同じパーツがあるので、数値化しやすい。左右の目が4cm離れた人を5.5cm離れた人に10段階で近づけていくには1.5mmづつ離していってやればいいわけだ。黒人の肌を白人のそれにするには色の中間色を経過音的にいれてやればいい。中間画像が一杯あるほど、むにゅーんと変化する顔がつくれるわけです。

実際には異なる2つの画像をつなぐ中間画像を細かくつくっていくことで、変化の変わり目をわかりにくくさせるやり方です。なので、このように左右の視点で同じ人の顔を捉えることで、擬似的な3D合成にもつかえる。

でも、今回モーフィングしてんのは顔じゃぁああないんだよ!

シーンAからBに切り替わるわけだけど中間ってなんだ!???

特徴点分析をかけて特徴量ごとにQuadrangulationみたくメッシュ化して・・・できんの??

これはコマ送りで、抜き出した画像。

AとBの中間にあらわれるこの映像。

AとBを合成したってこんな、正面からの撮影映像はでるわけがないんだよ・・・

こんな画像がでてきちゃった時点でモーフィングだけでは説明がつかない。

超多視点撮影

アメリカ人気のSuperbowl では、超多視点のEyeVisionなどが導入されている。

サッカーとかでも使われているのを見たのでだいぶ一般化してきたのかもしれない。

↑

こういうの。20〜35秒ぐらいの部分を参照。

元画像から推測して合成なんてだるいこと言ってないで、その中間になる部分の映像も撮影すればいいじゃないの、といういかにも物量にものを言わせるアメリカ流。

ライブステージは固定なので、アメフトのようにカメラワークを連動させる必要はない。

もっと少ない台数と、低い設備投資で超多視点撮影と同じような効果を得ることができる。これなら、動いている絵をもとにモーフィングする必要がない。

でもね、

・・・。客いねぇな・・・・・・。

こんなの、スポーツ中継でつかわれるようなマルチアングル撮影のシームレススイッチングだけでは説明がつかないじゃないのさ・・・。説明がつかないことだらけ。

リハーサル時の3Dモデルとブレンド

Perfumeのダンスの細密な再現度があってこそなんだろうけど、予め3Dモデルに落とし込んだデータが用意されているであろうことは、カメラ視点がホークアイぶっとびの俯瞰になっていることからもわかる。

多視点撮影なのも間違いない。でも、その中間をつなぐのは仮想データなのではないか。

言い換えれば、仮想空間のライブに、現実空間で撮影したライブのほうの映像を合成している。だからカメラアングルは自由自在に、カメラを動かした映像として出力できる。

同時にステージ上に展開しているプロジェクションマッピングも制御できるし一石二鳥だね!

ってな具合で、分析したつもりだけど、ほんとなんのこっちゃだよね。少なくとも中間画像はなんらかの形で作られていると思うんだけど、お手上げだよ。これ、静止画じゃないんだよ、カメラスイッチング中も客席が動いてるんだよ・・・。リアルタイムで、こんな速度でできるのかね?

予めリハーサル動画のほうで中間画像を合成していおいてるのかなとおもったんだけど、そんなちゃっちなもんじゃないんだよね・・・。

しかもこれが録画じゃなくストリーミングされたってのが、もう未来すぎて、絶句ですわ。

SxSWだし謎のテクノロジーがつかわれてるんだろうなと納得させるしかないのでありました。

推測結論

複数台のいろいろなアングルからのカメラからの撮影動画を、切り替えるときに、途中経路のカメラ映像を差し込んでカメラ間のスイッチングをスムーズモーフィングにしている。

その時、繋ぎ目を分かり難くするために仮想空間上の3Dモデルからの映像を混ぜることでシームレスにしている。

中間画像合成まではせずに、アルファブレンドの透過度を変更し、視覚効果をまぜることでぼかしている。

どこかで答えあわせ期待したいですね。

ちなみに

あーちゃん派です

追記

現地でみてた人の段によればカメラは10台ぐらいだったってYO!

コメントを残す