昨日の続き。

5~6年前につくった奴で、マルチもにっとというものがある。

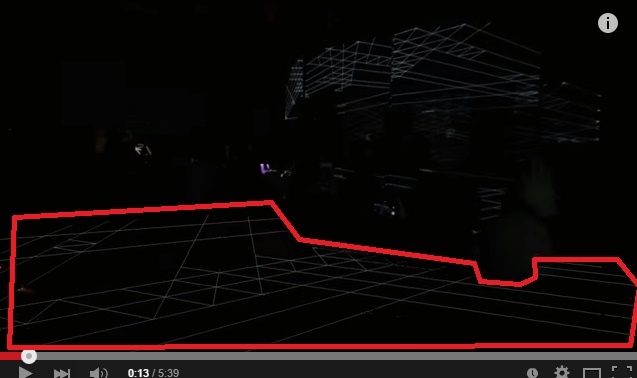

遠隔操作型の多脚戦車だのにエアガンとカメラを積んで、ロボでサバゲというのをやってる人の要望でYoutubeやustreamのモニターを1画面で読み込めるようにした何かだ。自分の技術系のブログのほうのドメインをうっかりロストしたあげく、業者に拾われてしまったのでこっちに最低限サルベージしておく。

http://kuippa.com/sandbox/multimonit/

画面のちょっとあれなアイコンをクリックすると全部同時に再生が始まる。止めるには左上のメニューから。

下部の動画をクリックするとメインモニタを切り替えることができる。

何年も前のyoutubeAPIやらustreamやらをつかっているので、動くもんかわからなかったけど動くもんだね。

すごいんだぜ、prototype.jsがでてきたんだぜ。jquery前のテクノロジーだ。

ActionScriptのFlex2か3あたりを使用しているのだけど、同じことをhtml5でやろうとしても、API側がプレイヤーをiflameで読み込ませるだけなので残念ながら同じことを再現するのはまだまだタフなことだとおもう。youtubeやustreamがhtml5のvideoタグ’video/mp4’あたりで対応してくれる未来があるならそのほうがいいと思うのだけど、まだちょっとむずかしい。あと何年かすればそうなるとは思うけど……

さて、話しが少しそれた。なんでこれを紹介したかというと、今年になってYoutube自身がその実験サイトでChooseYourViewというプレイヤーの実証をはじめたからだ。

https://www.youtube.com/user/MadilynBailey/ChooseYourView

まあ、コンセプトは一緒。

最近はフェスだの、ライブだのだと海外だと撮影自由なのでみんながステージに向かってカメラを構えている。

何か事件や事故があるとみんなが持っているスマートフォンで撮影をおこなう。

多視点映像が溜まってきた。

多視点視聴のソフトが必要になってきているんじゃないかと思ってね。

前述のは前時代的であるので、もっと現代風であるべきかとは思うんだけど。

それがオキュラスに流すとか、そういうものかもしれないけど。

まあChooseYourViewも結構だけど、もっと未来テクノロジーの鱗片を味わいたかった。

SxSWのperfumeのスムースモーフィング(PerfumeのSXSWライブでうにーっとなる謎の技術分析

)、あれと同じことが多視点映像がたまるとできるんじゃないかなと思っている。

プレイヤーの未来

楽器の習熟は幼少期からの絶え間ない反復練習。でもソフトウエア音源や自動演奏は一流プレイヤーでさえ再現できないような演奏もできるようになった。

かつてはペッラペラのMIDI音源だったものは、多くの人間が生音と区別ができないレベルにまで音情豊かになってきている。

正確さを競うという点で、人間はもはや敵う余地はなくなった。

しかし、上原ひろみのようなグルーヴが機械に出せるかはまだ別である。

サンプリング音源をいかに集めるかとか、カオスパッド的なものでゆらぎをあえて作るというような工夫はあるが、音楽のプレイヤーの重要度は下がり、パフォーマーの価値があがる一方である。残念ではあるが。

誰にでもできるようにするのが技術の目指す方向である以上、ぶつかりあうのはいたしかたのないこと。

科学技術の発展度合いを考えると、ピアノの発明と同程度のインパクトを持つ楽器の登場があってもよいと思うが、いまのところ決め手はない。

次の主軸はDJツールのようなものだろうか?

いずれにしろ非予見性、偶発性を残してくれる電子楽器のいずれかだろう。

ダンスをすることで音が奏でられるとか、もしかしたら、音を出させる指示というインターフェイスの部分での変化が一番直近の変化なのかもしれない。

クリエイターにまっているもの

ワトソンが作曲してくれる未来は既に来ている気がして、シンガー・ソングライターの作曲は数年前で既にあれだったし、Music Xrayのようなヒット曲を予測してくれる人工知能(実際登録するとスパムばかりきて参ってしまうサービス)なんてものも登場してきている。

正直クリエイターサイドの未来はよくわからない。あまり変わらないとも、まったく変わってしまうともなんとも予測がつかない。

作曲の段階で聴かせるためだけの創作じゃだめなのかもしれないね。

オペラとかそういう、どういうふうに聴かせるかというシチュエーションまで含めて創作なのかも。ゲーム・ミュージック的な。

で、なにつくるの?

なにしよう?

抽選が激しかったらしく、前回一緒のチームを組んだメンバーは半数以上が落選してしまった。

これからAPI眺めます。

上の、マルチモニットと同じ年代につくったNetvocaloidのswfは動かなくなってた(´・ω・`)…。

というかflexのコンパイル環境とかないし。せっかくasでvxmlの変換クラスつくったのにな。

アイディアソンでYamahaさんが6人ぐらい上京してきてて、netduettoやらnetvovaloidつくってた時代と同じぐらい気合はいってるらしいので期待大。